인공지능 ‘사이비’ 정보의 홍수

2023년 11월 OpenAI에서 챗GPT를 공개한 이후 등장한 다양한 생성형 인공지능 기술은 새로운 패러다임을 제시하고 있는 듯하다. 텍스트뿐만 아니라 이미지나 동영상도 거침없이 생산한다. 주어진 명령에 따라 그럴듯하게 시를 짓고 작곡도 하고 도표도 깔끔하게 그린다. 엑셀이나 코딩 실력은 엄청나다. 아무리 어려운 질문에 대해서도 불과 몇 초 만에 그럴듯한 대답을 척척 내놓는다. 그러나 그 답이 참이라는 보장은 전혀 없다.

그렇기 때문에 생성형 인공지능 기술이 특히 교육 현장에 미칠 영향은 즉각적이고 심각해 보인다. 그 활용 여부를 두고 외국 대학은 물론이고 국내 대학들이 심각한 고민에 빠져 있다. 인공지능에 대한 교육을 전폭적으로 확대해야 한다는 주장이 이제 지극히 당연한 것으로 설득력을 더욱 얻고 있는 가운데 많은 대학에서 인공지능 관련 교수학습가이드라인을 발표하는 등 발빠르게 대처하고 있다. 그러나 생성형 인공지능 기술을 학생들에게 허용하는 것에 대한 반대의 목소리도 결코 적지 않다. 왜냐하면 생성형 인공지능 기술은 ‘진리추구’와 ‘노력’이라는 교육의 본원적 가치를 근본적으로 훼손하는 것처럼 보일 뿐만 아니라 학생들의 창의력 증진을 방해하면서 표절에 대해 무감각하게 만들어 결국은 지적 절도 행위를 조장하여 윤리의식 자체를 훼손할 수 있기 때문이다.

특히 세계적 권위를 인정받고 있는 학술지 『사이언스(Science)』에서는 학술 논문 심사에 대한 새로운 가이드라인을 발표하면서 챗GPT가 생산한 도표나 이미지를 사용할 경우 연구 부적절 행위로 간주하겠다고 선언하였다. 이와 쌍벽을 이루는 『네이처(Nature)』 역시 인공지능은 책임 능력과 설명 능력이 없다는 이유 때문에 학술 논문의 저자가 될 수 없다고 선언하였다. 세계적인 언어학자인 노엄 촘스키 역시 챗GPT는 ‘거짓 약속’에 불과하며 결국 우리의 학문과 윤리를 격하시킬 것이라고 경고한다.

그럼에도 불구하고 챗GPT와 더불어 다양한 인공지능 기술이 지속적으로 등장하면서 다양한 디지털 정보들이 폭발적으로 재생산될 것이다. 그런데 최근 한 보고에 따르면 전문학술지의 심사자들조차 챗GPT 등 인공지능 기술을 통해 재생산된 자료 중 60% 정도밖에 확인하지 못하였다고 한다. 이런 상황에서 무엇보다 중요한 것은 디지털 리터러시이다. 디지털 리터러시란 디지털 정보를 제대로 이해할 수 있는 능력을 말한다.

챗GPT는 OpenAI에서 스스로 밝히고 있듯이 ‘그럴듯한’ 이야기를 너무나도 생생하게 제시하고 있지만 현실이 정말 그렇다는 보장은 전혀 없다. 그래서 환각이 나타나는 것이다. 따라서 인공지능이 재생산한 내용이 현실과 일치하는지 냉철히 판단할 수 있는 능력, 즉 통계적 가능성을 바탕으로 앵무새처럼 지저귀는 것이 아니라 ‘사이비’ 정보에 현혹되지 않는 건강한 이해 능력을 갖추는 것이 무엇보다 시급하다.

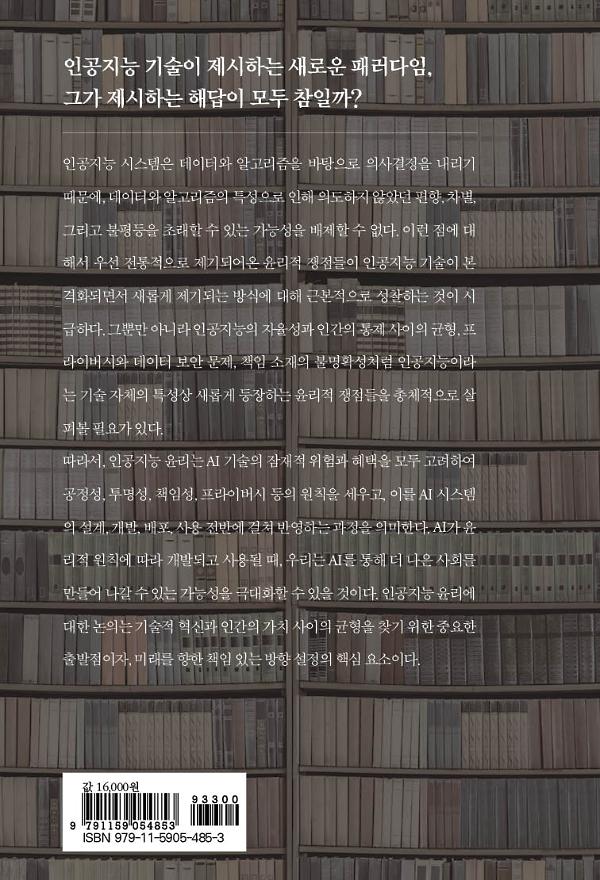

기술적 혁신과 인간의 가치의 균형을 찾기 위한 중요한 출발점

인공지능 시스템은 데이터와 알고리즘을 바탕으로 의사결정을 내리기 때문에, 데이터와 알고리즘의 특성으로 인해 의도하지 않았던 편향, 차별, 그리고 불평등을 초래할 수 있는 가능성을 배제할 수 없다. 이런 점에 대해서 우선 전통적으로 제기되어온 윤리적 쟁점들이 인공지능 기술이 본격화되면서 새롭게 제기되는 방식에 대해 근본적으로 성찰하는 것이 시급하다. 그뿐만 아니라 인공지능의 자율성과 인간의 통제 사이의 균형, 프라이버시와 데이터 보안 문제, 책임 소재의 불명확성처럼 인공지능이라는 기술 자체의 특성상 새롭게 등장하는 윤리적 쟁점들을 총체적으로 살펴볼 필요가 있다.

따라서, 인공지능 윤리는 AI 기술의 잠재적 위험과 혜택을 모두 고려하여 공정성, 투명성, 책임성, 프라이버시 등의 원칙을 세우고, 이를 AI 시스템의 설계, 개발, 배포, 사용 전반에 걸쳐 반영하는 과정을 의미한다. AI가 윤리적 원칙에 따라 개발되고 사용될 때, 우리는 AI를 통해 더 나은 사회를 만들어 나갈 수 있는 가능성을 극대화할 수 있을 것이다. 인공지능 윤리에 대한 논의는 기술적 혁신과 인간의 가치 사이의 균형을 찾기 위한 중요한 출발점이자, 미래를 향한 책임 있는 방향 설정의 핵심 요소이다.